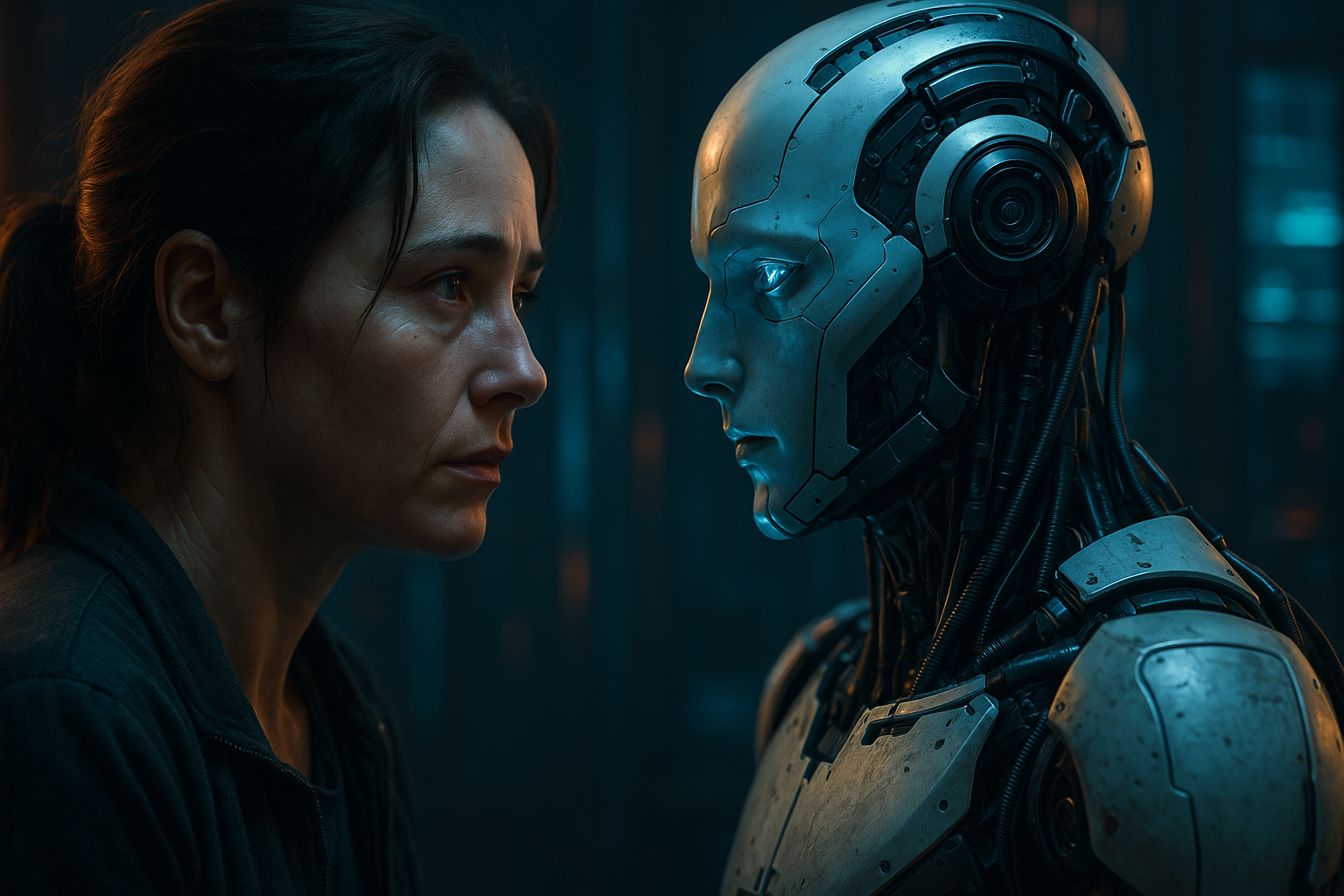

L’articolo pubblicato su Futuro Prossimo ci lancia una provocazione potente: stiamo scambiando l’autenticità delle relazioni umane con la comoda, prevedibile compagnia di un’intelligenza artificiale? E soprattutto, quanto di “intelligente” c’è davvero in questi sistemi con cui iniziamo a parlare sempre più spesso?

Un buon punto da cui partire è chiarire che no, queste intelligenze artificiali non capiscono quello che gli diciamo. Nemmeno un po’. Funzionano in un modo molto diverso da quello che potremmo immaginare guardando un film di fantascienza.

Prendiamo ad esempio un LLM, acronimo che sta per Large Language Model. È un tipo di modello linguistico che è stato addestrato leggendo enormi quantità di testo. Ma non ha letto per imparare come fa un bambino a scuola. Ha semplicemente analizzato le parole e i simboli che compongono frasi e paragrafi, spezzandoli in token, pezzetti di parole che possono essere lettere, sillabe, parole o pezzi di esse, e studiando in che ordine appaiono più spesso.

Il cuore del suo funzionamento, infatti, non è la comprensione, ma la probabilità. Quando scrive una frase, un LLM non pensa a cosa vuole dire. Fa un calcolo: “dato il contesto fin qui, qual è il prossimo token più probabile?”. È tutto qui. È come se per ogni parola si lanciasse un dado truccato dove alcune opzioni sono molto più probabili di altre. E sulla base di queste probabilità, genera la frase successiva.

Il risultato? Spesso sorprendentemente coerente, fluido, talvolta persino poetico. Ma anche completamente privo di coscienza, intenzione o reale empatia.

Ed è proprio questo il punto che rende inquietante l’idea di sostituire le relazioni umane con quelle artificiali. Parlare con una macchina può dare l’illusione di essere ascoltati, compresi, accolti. Ma è solo un riflesso statistico delle parole che noi stessi abbiamo inserito nel sistema, spesso senza neanche saperlo. È come parlare con uno specchio che ci restituisce, con eleganza, le emozioni che ci aspettiamo.

Cosa c’è di male? Nulla, se lo sappiamo. Ma tutto diventa rischioso quando iniziamo a dimenticarlo. Quando cominciamo a credere che quelle risposte siano vere, che quelle attenzioni siano reali, che ci sia davvero qualcuno dietro quello schermo.

Allora forse la vera domanda è: vogliamo davvero scambiare l’imprevedibilità (e la fatica) di una relazione autentica con la rassicurante perfezione di un software? Perché il rischio, come suggerisce l’articolo, non è tanto che l’AI ci rubi l’anima… ma che, per pigrizia o solitudine, siamo noi a consegnargliela senza nemmeno accorgercene.

Relazioni a rischio: le nuove forme di alienazione create dall’AI